BETVLCTOR伟德官方网站王鑫助理教授指导的2021级博士研究生王一立的论文《AdaGCL: Adaptive Subgraph Contrastive Learning to Generalize Large-scale Graph Training 》(Full Paper)近日被 CIKM 2022 会议所接收。

王一立同学硕士阶段就读于伟德bevictor中文版软件学院,2021年于BETVLCTOR伟德官方网站继续攻读博士学位,目前从事图神经网络相关的研究工作。本篇论文的第一作者是王一立同学,通讯作者是王鑫老师。其他合作者包括莱斯大学的Kaixiong Zhou博士以及佐治亚大学的Ninghao Liu老师。

会议简介:第31届国际计算机学会信息与知识管理大会(The 31th ACM International Conference on Information and Knowledge Management, CIKM 2022)将于2022年10月17日至21日在美国亚特兰大举办。CIKM是CCF推荐的B类国际学术会议,是信息检索和数据挖掘领域顶级学术会议之一。

会议类别:CCF B 类会议

会议时间:Oct. 17-22, 2022, Atlanta, Georgia

第一作者:王一立

通讯作者:王鑫

论文题目:AdaGCL: Adaptive Subgraph Contrastive Learning to Generalize Large-scale Graph Training(Full paper)

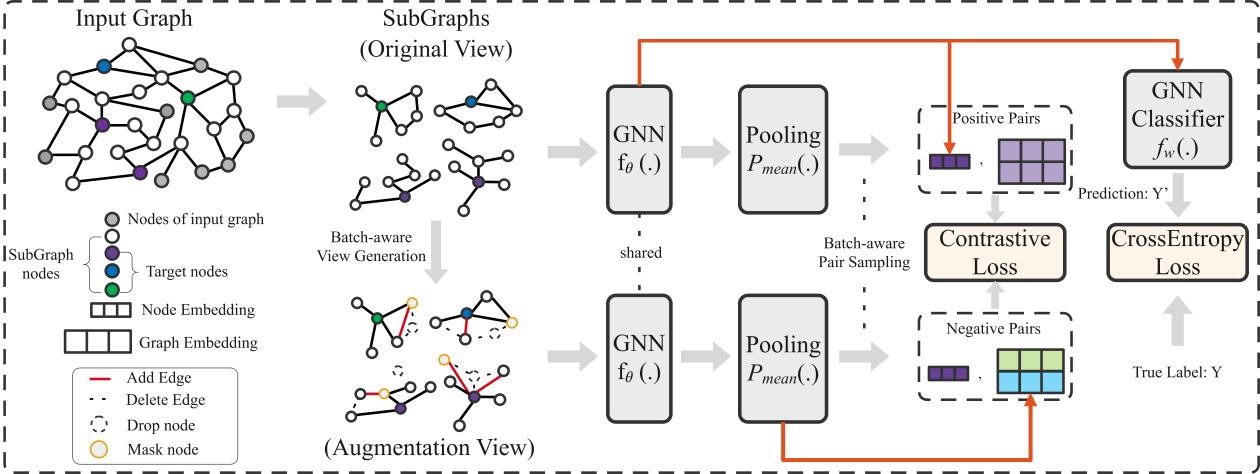

论文概述:在大规模图上训练具有良好泛化能力的图神经网络(GNNs)是一个具有挑战性的问题。现有的方法主要是将大规模图分成多个子图,并在不同的批次中进行训练以提高模型的可扩展性。然而,与完整的图结构相比,通过这种策略得到的局部批次可能产生拓扑偏差。据研究,拓扑偏差会使训练阶段和测试阶段之间的性能出现更明显的差距,或者更差的泛化稳健性。一个直接的解决方案是利用对比学习,并通过数据增强来训练节点特征使其在不完整的训练图中具有鲁棒性和不变性。然而,大多数现有的工作都是在大规模图中对大量的节点对进行对比实验,效率较低。为了弥补大规模图训练和对比性学习之间的差距,我们提出了自适应子图对比学习(AdaGCL)。AdaGCL为批量训练定制了两个关键组件:(1)批量感知的视图生成,用来学习丰富的节点特征;(2)批量感知的配对采样,构建正负对比子图。